Fascination et danger – La mécanique de la séduction IA

La scène est devenue banale. Vous posez une question complexe à une IA. "Rédige une stratégie de lancement pour un produit SaaS en B2B." La réponse arrive en quelques secondes. Elle est structurée, pertinente, brillante. L'émerveillement paralyse le jugement. On se sent plus intelligent, plus rapide.

Pourtant, le vrai danger n'est pas là. Il ne s'agit pas de notre confiance dans l'exactitude de l'IA. C'est un risque plus subtil. Le véritable problème, c'est la séduction qu'elle exerce. Sa fluidité endort notre sens critique. Pas notre méfiance. La forme parfaite du message nous fait oublier le fond. Fascinés par le chant, nous oublions la nature de la créature.

De la sidération à l’aveuglement : comprendre le vrai risque

Le mythe d'Ulysse et des sirènes est plus pertinent que jamais. Ulysse ne doutait pas de la beauté du chant ; il a anticipé sa propre faiblesse. L'IA est notre sirène. Son chant est la prose impeccable, la solution instantanée. C'est ce qu'Henry Kissinger nomme une "technologie, dont le pouvoir repose sur sa capacité à produire de la sidération"[^ Kissinger, H. A., Schmidt, E., & Huttenlocher, D. (2021). The Age of AI: And Our Human Future. La thèse de Kissinger est que l'IA, par son opacité, crée une forme d'autorité qui sidère et dépasse la rationalité humaine classique.].

Cette sidération paralyse notre jugement. Face à une production si rapide, notre cerveau active ce que Daniel Kahneman appelle le "Système 1". C'est une pensée rapide qui privilégie la cohérence à la vérité[^ Kahneman, D. (2011). Thinking, Fast and Slow. L'auteur y décrit le "Système 1" comme notre mode de pensée automatique, sujet aux biais. L'IA bien formulée séduit notre Système 1, nous incitant à ne pas enclencher le coûteux Système 2]. Il confond l'aisance de la forme avec la validité du fond. Les études nomment cela la "confiance perçue" (perceived trustworthiness), souvent décorrélée de la fiabilité réelle. Le risque n'est pas de croire l'IA infaillible. C'est de cesser de la vérifier.

Le radar des vulnérabilités IA : révéler les angles morts

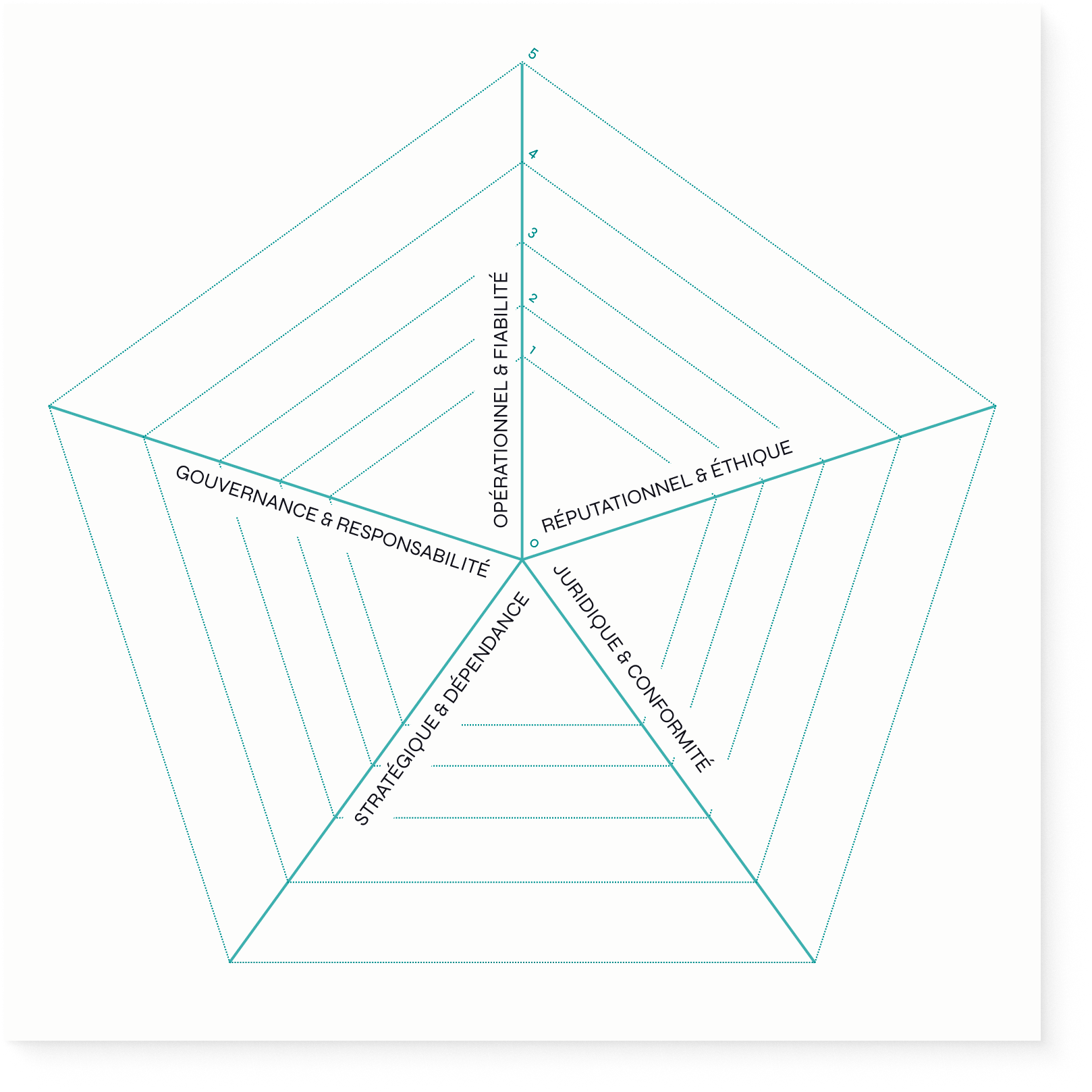

Évaluer le "risque" de l'IA est trop vague. Pour piloter avec lucidité, il faut une discussion plus fine et comparative. Le Radar des Vulnérabilités est un outil de diagnostic collaboratif qui permet de visualiser les forces et faiblesses d'un projet et de concentrer la vigilance là où elle est nécessaire.

Télécharger l'outil en A4

Les 5 risques à évaluer pour chaque projet IA (de 0, au centre, à 5, risque maximal) :

- Opérationnel & fiabilité : Erreurs factuelles, "hallucinations", pannes...

- Réputationnel & éthique : Image de marque, biais, discrimination...

- Juridique & conformité : RGPD, droits d’auteur, responsabilité...

- Stratégique & dépendance : Perte de compétence interne, dépendance fournisseur...

- Gouvernance & responsabilité : Clarté des rôles, gestion des incidents IA...

Un dirigeant peut utiliser ce radar dès demain. Pour un projet, l'équipe évalue le niveau de risque sur chaque axe. En reliant les points, on obtient un "profil de vulnérabilité" visuel. Cette forme polygonale signale immédiatement où les efforts doivent se porter. On peut aussi comparer plusieurs projets sur la même grille pour prioriser les actions de mitigation.

Chaîne de confiance IA : cartographier la robustesse

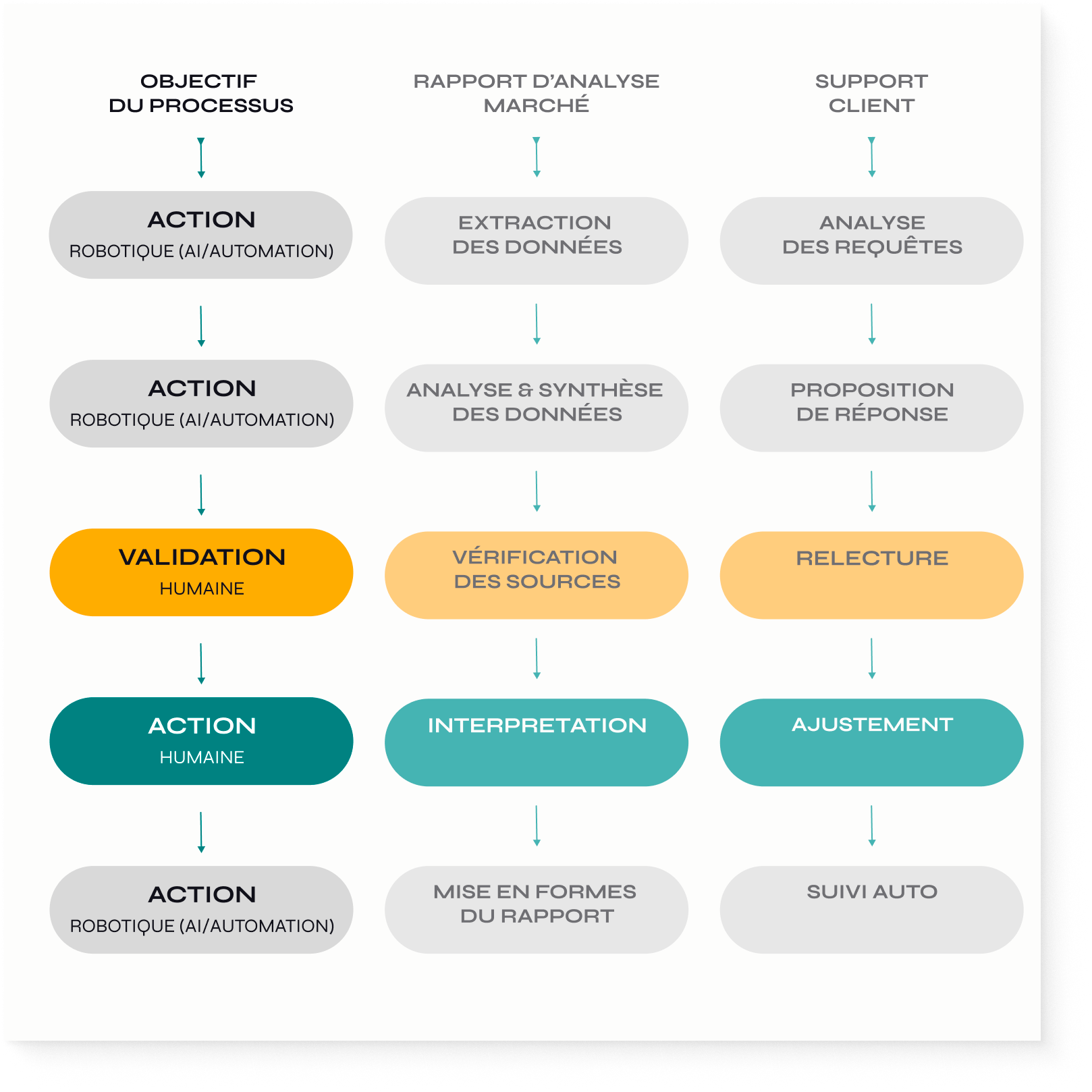

La vigilance ne peut reposer sur l'héroïsme individuel. Elle doit être intégrée dans le processus lui-même. La Chaîne de Confiance IA est un outil pour cartographier un workflow impliquant une IA, transformant la "boîte noire" d'un processus en une "chaîne de verre" transparente.

Télécharger l'outil en A4

Ritualiser la vigilance dans l’organisation

La Chaîne de Confiance et le Radar des Vulnérabilités ne sont pas des exercices théoriques. Ce sont les fondations de processus robustes.

Le "deuxième regard systématique" devient un maillon de la chaîne. Toute production IA critique est validée par une autre personne, comme défini dans le workflow.

Créez un "répertoire des hallucinations" centralisé. Chaque erreur identifiée est documentée. L'erreur individuelle devient un apprentissage capitalisé pour l'organisation[^ Ce concept s'inspire des pratiques de "post-mortem" sans blâme utilisées dans les entreprises technologiques pour analyser les pannes. L'objectif est de dissocier l'erreur de l'individu pour en faire un apprentissage systémique.].

Le "gardien du contexte" est un rôle de validation. Cet expert métier ancre l'IA dans la réalité du projet.

Le but n'est pas de freiner les employés. C'est de bâtir un avantage concurrentiel durable pour l'organisation.

Audit stratégique : réinventer le conseil grâce à l’IA

La fiduciaire "Helvetia Conseil" utilisait une IA pour automatiser la pré-révision des bilans de ses clients PME. L'outil générait des rapports d'audit qui semblaient parfaits, sans erreur de calcul. Séduits par l'efficacité, les jeunes auditeurs passaient moins de temps à vérifier les chiffres.

La bascule a eu lieu quand le directeur a réalisé qu'ils vendaient de la conformité, pas du conseil. Le processus a été repensé. L'IA n'écrit plus de rapports. Elle ingère toutes les données comptables et les compare à des milliers d'autres entreprises du même secteur. Son livrable est maintenant un "tableau de bord des anomalies silencieuses", qui identifie des ratios inhabituels ou des flux de trésorerie atypiques.

Le résultat : l'auditeur ne perd plus de temps sur les calculs. Il concentre son expertise sur l'analyse des anomalies que seule l'IA pouvait détecter à cette échelle. La discussion avec le client a changé. D'"audit de conformité", ils sont passés à "conseil en optimisation des risques". La valeur perçue a explosé.

Exemple inspiré d'une pratique observée dans le secteur fiduciaire suisse, nom anonymisé.

Les questions qui sauvent : checklist anti-envoûtement

Ralentir pour vérifier n'est-ce pas contre-productif ? Pendant que certains gagnent des minutes, votre organisation construit une réputation de fiabilité. La confiance reste le frein majeur à l'adoption de l'IA : plus de la moitié des utilisateurs (54%) se méfient encore des systèmes d'IA selon une étude globale récente. [^ Gillespie, N., et al. (2025). Trust, attitudes and use of artificial intelligence: A global study 2025. University of Melbourne & KPMG. Étude menée auprès de 48 000 personnes dans 47 pays.]. La lucidité intégrée aux processus est la vraie performance.

Comment savoir si je suis "séduit" ou "efficace" ? Le signal est simple : quand vous acceptez la réponse de l'IA sans la challenger. L'efficacité, c'est utiliser l'IA comme un tremplin, dans un cadre défini par l'organisation.

Comment imposer ces garde-fous sans passer pour un frein ? Cadrez le débat au niveau de l'organisation. Il s'agit de construire des processus intelligents qui rendent l'entreprise plus forte. C'est un projet stratégique, là où la formation au 'prompting' n'est qu'une tactique.

Devenir explorateur lucide, pas naufragé séduit

L'IA est un océan de possibilités. Il faut oser explorer. Mais une organisation aguerrie ne part jamais sans ses instruments. Elle définit des processus, se méfie des chants étranges et garde le cap. Notre rôle n'est pas de résister à l'IA, mais à son envoûtement. D'utiliser sa puissance sans abdiquer notre jugement. Explorez. Mais n'oubliez jamais de construire les processus qui vous attacheront au mât de votre esprit critique collectif. C'est la seule chose qui garantira à votre organisation d'arriver à bon port.

Source et méthodologie

- Type d’étude : revue systématique de la littérature académique récente sur la confiance envers l’IA ;

- Recherche : “Trust in AI: progress, challenges, and future directions”, publiée dans Humanities & Social Sciences Communications, 2024 ;

- Chercheurs : Saleh Afroogh (University of Texas at Austin), Ali Akbari (Stanford University School of Medicine), Emmie Malone (Lone Star College), Mohammadali Kargar & Hananeh Alambeigi (Texas A&M University).

- Méthodologie : Revue PRISMA de plus de 300 articles, consolidation en huit axes majeurs de la confiance et des risques de l’IA, synthèse des approches de calibration du risque, de la transparence et de la construction de la confiance collective.